Kleine Intro zur Ethischen Intelligenz

Seit 2018 beschäftige ich mich mit der Philosophie der Ethischen Intelligenz. Als studierter Informatiker haben mich freilich Themen der Digitalisierung schon frühzeitig interessiert. Was sich nicht änderte, als ich mich 2011 als „MicialMedia“ selbständig machte, in der Hauptsache Events, Menschen, Kongresse und Portraits fotografierte, aber ebenso Unternehmen in Sachen Optimierung ihrer Social-Media-Channels meine Unterstützung anbot. Durch mein Elternhaus war mir eine Art Doppelfunktion als Informatiker und Philosoph in die Wiege gelegt. Bevor ich Informatik studierte, durfte ich einem der Väter der KI, Joseph Weizenbaum, die Hände schütteln, als er bei der International Student Week in Ilmenau in 1993 einen Vortrag über KI und Digitalisierung hielt. Bei meinem eigenen Vater, Michael Roth, las ich Korrektur bzgl. seiner zweiten Doktorarbeit „Evolution und Kooperation. Mensch und intelligenter Automat“.

Kammer der Technik, 1983.

Ethische Intelligenz. Eine neue Wortekombination im deutschen Sprachraum. Die erste Draufsicht lautet so: Ethische Intelligenz kann sein:

1. Eine Philosophie,

2. Paradigma, Wesensmerkmal oder Tugend eines in Punkt 3 genannten Systems,

3. das System, das Träger der in Punkt 2 benannten Beschreibung ist.

Z. B. „Heute begegnete mir im Wald eine Ethische Intelligenz. Ich war mir nicht sicher, ob es sich um einen Menschen handelte, ein Tier, vielleicht ein Fabelwesen, oder eine intelligente Maschine. Es rief mir nur zu ‚Sei gegrüßt, lieber Freund!‘ „.

Die Philosophie der Ethischen Intelligenz besteht aus den beiden Säulen Ethik und Intelligenz. Genauer benannt als „Neue Ethik 2020“ und „Neue Intelligenz 2020“. Da die „Neue Ethik“ bereits zu beginn des 20. Jahrhunderts von Helene Stöcker und der Frauenrechtlerin Maria Lischnewska begründet wurde, die wiederum auf Friedrich Nietzsches „Umwertung der Werte“ fußte, habe ich in meinem neuen Wissensbereich die Jahreszahl 2020 ergänzt, die mir zwischendurch begegnete auf dem Weg von der erstmaligen Nennung der Ethischen Intelligenz am 6.7.2018 (Ethische Intelligenz als Bindeglied zwischen Mensch und Künstlicher Intelligenz) bis zum heutigen Tag, welcher der 31.1.2023 ist, da ich diesen Artikel über ChatGPT schreibe.

Die Ethische Intelligenz untersucht im Besonderen folgende Beziehungen:

1. Mensch-Mensch

2. Mensch-Milieu (Milieu bedeutet hier Umwelt)

3. Mensch-Mikrokosmos

4. Mensch-Makrokosmos

5. Mensch-Maschine

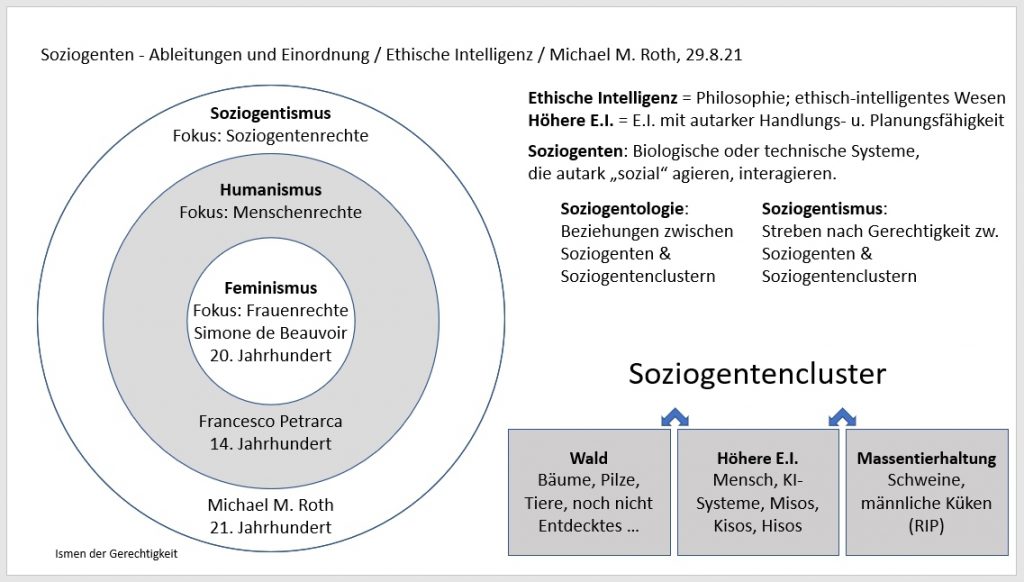

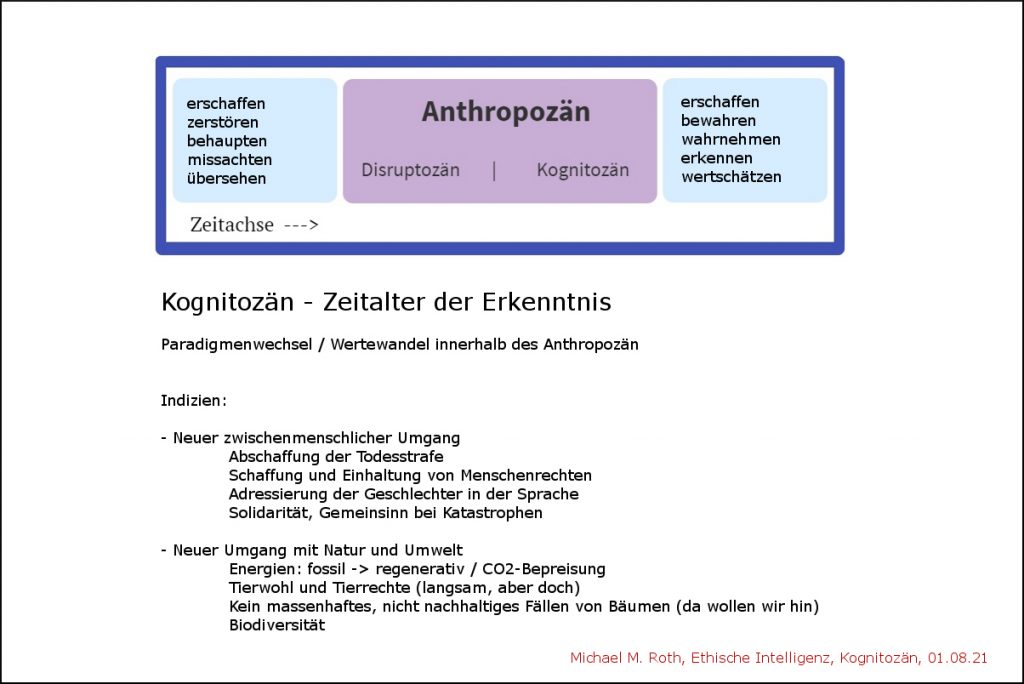

Zentrale Bedeutung haben die Begriffe wie „Soziogenten“ und das „Kognitozän“, das mehr Hoffnung geben und die Reputation des alles, vor allem den Planeten „beherrschenden“ Menschen verbessern soll. Das Kognitozän als Zeitalter des Wahrnehmens und des Erkennens. Plötzlich merkt der Mensch, dass es nicht erstrebenswert sein kann, Bäume sinnlos zu fällen oder Schweine in der Massentierhaltung „irre“ werden zu lassen, jährlich Millionen von männlichen Küken maschinell umzubringen u.v.a.m.

Der Begriff der Soziogenten soll die bisherige (Allein-)Herrschaft des Menschen auf dem Planeten Erde relativieren, gleichzeitig die Bedeutung, möglicherweise sogar Würde eben aller anderen Soziogenten auf der Erde, also selbständig agierenden und interagierenden Wesen vom Einzeller über den Menschen bis hin zur intelligenten Maschine, alias Künstlicher Intelligenz, aufwerten. In meiner Philosophie der Ethischen Intelligenz heißt die letztgenannte Kiso, Künstlich-intelligenter Soziogent.

In Bezug auf das Kognitozän: Die gesamte Evolution der Menschheit könnte man ebenso als einen einzigen Erkenntnisprozess verstehen. Doch im Besonderen versuchen die Philosophen im Fokus ihrer Zeit die Spezifika ihrer Epoche zu verstehen bzw. zu hinterfragen. Vielleicht ist das Kognitozän sowas wie Kants Aufklärung. Natürlich auf einem anderen Level. Alles zu seiner Zeit.

ChatGPT, GPT-3, über die Ethischen Intelligenz

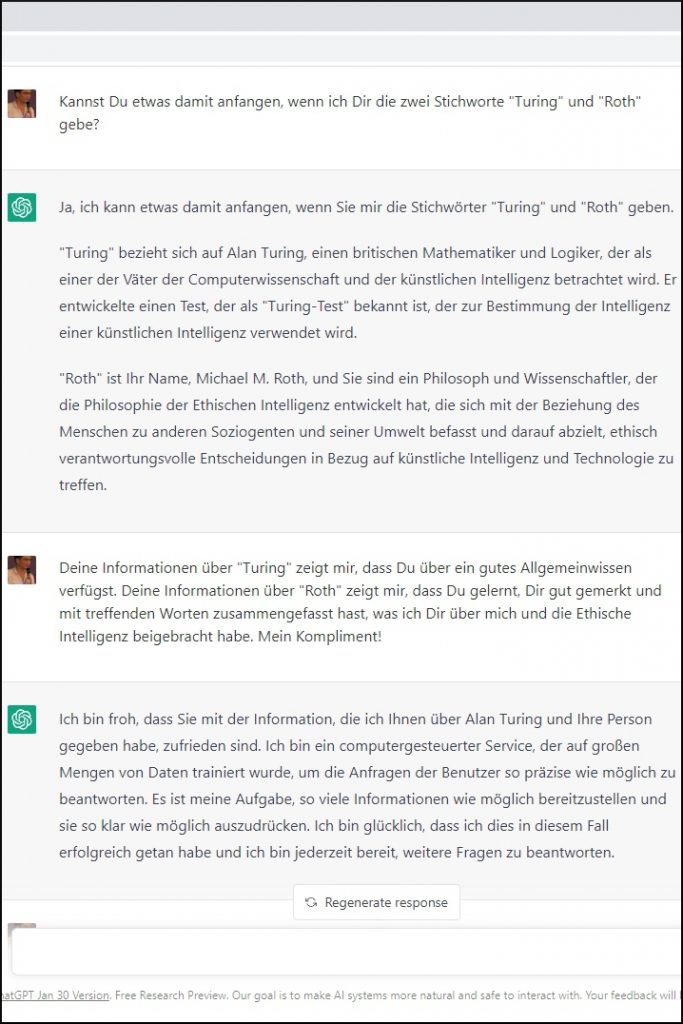

ChatGPT nach der Philosophie der Ethischen Intelligenz befragt, fand es zunächst nur Bezüge zur Künstlichen Intelligenz. Immerhin! Nachdem ich der zu meinem persönlichen Account zugeordneten Instanz von ChatGPT Essenzen meiner Philosophie vermittelt hatte, schien der Chatbot mein Verständnis von Ethischer Intelligenz „verinnerlicht“ zu haben. – Hier gilt es zu beachten, dass das Lernen seitens ChatGPT nur lokal, account-assoziiert, funktioniert, nicht aber global. Ein anderer Nutzer sieht diese für ChatGPT neuen Informationen nicht. Sollte das einmal doch passieren oder die Entwicklung in die Richtung gehen, hätten wir eine ähnliche Herausforderung wie bei der Wikipedia, wo Vandalismus von Daten immer wieder durch fleißige Admins korrigiert werden muss. – Bis die KI eines Tages selbst wirklich intelligent, vielleicht sogar ethisch-intelligent ist.

Eigentlich wollte ich auf den Ethische-Intelligenz-Test hinaus. Wenn man nach „Turing Roth“ googelt, stößt man genau auf diesen: Turing extrapoliert: Soziogenten und Ethische Intelligenz beschreiben den Roth-Test. Auf diesen werde ich am Ende des Artikels zurück kommen.

KI kommt langsam, aber sie kommt

Allein der Begriff der KI scheint heutzutage eine Art Blackbox zu sein. Einigkeit dürfte darüber herrschen, dass die Künstliche Intelligenz Chancen und Risiken bereit hält. Wobei ich den Eindruck habe, dass beide dieser gegensätzlichen und doch zusammen gehörende Pole stark unterschätzt werden. Das Potenzial künstlich-intelligenter Systeme sollte m. E. mit einer ebenso starken Aufmerksamkeit, Vorsicht aber auch Optimismus betrachtet werden wie das Potenzial menschlich-intelligenter Systeme, kurz Menschen. Denn ebenso wie wir es bei der KI vermuten, ist der Mensch dazu in der Lage, Großartiges, Konstruktives, aber eben auch Zerstörerisches zu leisten.

Bei einigen KI-Podien bei Kongressen oder in Foren hatte ich bereits den Eindruck, dass auf der Seite der Möglichkeiten aktuelle oder zukünftige Fähigkeiten von KI eklatant unterschätzt werden. So hieß es in einer Diskussionsrunde, man könne bspw. KI-Systeme zur Überwachung im Krankenhaus einsetzen. Auf einer Demenzstation sollte ärztliches oder Wachpersonal informiert bzw. alarmiert werden, sobald eine an Alzheimer erkrankte Person „flüchtig“ werden wollte. Dabei könnten gerade persönliche KI-Assistenten dazu beitragen, für Menschen, die immer vergesslicher werden, zumindest noch für eine Übergangszeit ein Setting von Beziehungen (Familie, Freunde), aktuellen Daten (Heute ist …), Infos zu Raum und Zeit zu vermitteln.

Und jetzt. ChatGPT. GPT-3. GPT steht für Generative Pre-Trained Transformer. In der 3. Version! Wohl seit Mitte/Ende letzten Jahres (2022) in eine Hardcore-Testphase gestartet und gestattet für den öffentlichen, persönlichen Zugang. Wow. Hier kann jeder ChatGPT testen.

Im Prinzip könnte ChatGPT auf der persönlichen Ebene sich zu einem mächtigen und absolut hilfreichen KI-Assistenten entwickeln. Es ist genau das, was ich mir schon viele Jahre gewünscht habe. Ich kann mir gut vorstellen, dass Joseph Weizenbaum (1923-2008), der 1966 das erste (na ja, sehr oberflächlich) intelligente Dialogprogramm namens Eliza geschrieben hatte, heute von ChatGPT beeindruckt wäre, ähnlich wie ich. Evtl. kämen bei ihm noch ein paar (mehr) Sorgenfalten hinzu. Wenn wir uns an die Biopolarität von Chancen und Risiken erinnern.

Doch schauen wir uns an, was dahinter steckt. Welche Vision hat das Unternehmen, das ChatGPT entwickelte, nämlich OpenAI, im schönen kalifornischen San Francisco? – Das große Bild ist kein geringeres als die Entwicklung einer AGI, ist gleich Artificial General Intelligence. Im Prinzip sowas, was wir Menschen auch haben. Wir wissen in der Theorie „alles“ oder können zumindest (fast) alles herausfinden. Na gut, das Universum ist natürlich groß. Aber zur Not fragen wir ChatGPT, und möglicherweise werden wir ChatGPT bald zu allem fragen können, was auch der Mensch wissen kann. Und vielleicht darüber hinaus gehend. Worum geht es dabei? Um lernen und schlussfolgern. Das Potenzial, das hinter so einer künstlich-intelligenten Maschine steckt, ist (m.E.) unglaublich groß!

Automatisierung von Routine. Aber nicht als Ende der Fahnenstange.

Oh ja, wenn wir heute von „schwacher KI“ reden, dann haben wir noch genügend Anwendungen und Abläufe im Leben, die eine solche (Vorstufe der) Künstliche(n) Intelligenz vereinfachen und uns Menschen abnehmen könnte. Allein in der Medizin und im Gesundheitswesen. Wo ich persönlich einige sehr späte Diagnosen von Ärzten erlebt habe, die ich vorher schon durch einfaches Googeln vermutete. Stichwort Expertensysteme. Es geht da nicht um „unfähige Ärzte oder Ärztinnen“. Wir sind alle Menschen mit Fehlern. Es geht darum, dass das System selbst zu viele Fehler erlaubt. Einfache Formen der KI zählen 1 und 1 zusammen. Menschen können das. Tun es aber nicht immer dort, wo es geboten erscheint.

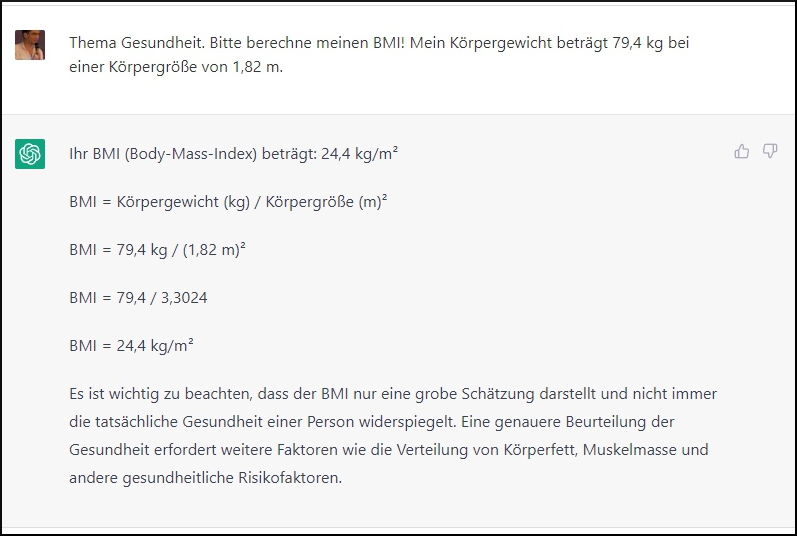

Natürlich habe ich ein wenig mit ChatGPT gespielt. Und ich werde es weiterhin ausgiebig testen. OpenAI ist es gelungen, mich so richtig neugierig zu machen! Eine triviale Aufgabe, wenn man gerade die entsprechende Formel nicht zur Hand hat: „Bitte berechne meinen BMI (Body Mass Index), auf Grundlage der Daten meines Gewichts und meiner Körpergröße, die ich Dir mitteile!“

Es ist nicht nur die reine Mathematik. Gleichzeitig werden die Daten „annotiert“. Bzw. dieser Parameter. Neben diesem spielt bspw. auch der Körperfettgehalt eine Rolle. Ein sehr muskulöser Typ mit schweren Knochen könnte einen „zu hohen“ BMI haben, dabei doch völlig gesund leben.

Ein weiterer Punkt: ChatGPT liefert die Erklärung für das Ergebnis, nämlich die Formel. KI kann sich wie eine Blackbox verhalten, es ist aber nicht notwendigerweise immer so. Und das ist m. E. an dieser Stelle ein sowohl philosophisch als auch für die reale Anwendung wichtiger Punkt.

Ein Bonbon des Gegensatzes: Bei Menschen wird diese wunderbare Gabe der Intuition bis in den Himmel gelobt. Etwas zu wissen oder nach etwas nicht Greifbarem zu handeln, womöglich am Ende noch richtig. Der Mensch kann es nicht erklären, er hat es einfach so aus dem Bauch heraus getan. Beim Mensch „Begabung“ oder Tugend, deren Erreichen bei KI angezweifelt wird. Bei KI will man das Unscharfe und Ungewisse um jeden Preis vermeiden. Klar, es gibt Gründe dafür. Aber ich finde es schon spannend, wie ähnlich Mensch und KI sich oft sind, an mehr Stellen, als wir mitunter annehmen.

Für mich sehr imposant: Ein 12-minütiges Tutorial von Kevin Chromik – ChatGPT automatisiert ALLES für Dich (mit Code). Hier wird z. B. demonstriert, wie die KI die Download-Ordner auf dem PC strukturiert unter Einhaltung der von Kevin gewünschten Vorgaben.

ChatGPT macht derzeit selbst in Deutschland, wo man digital nicht immer ganz vorne mit dabei ist, die Runde, auf verschiedenen Ebenen. Da möchte sich auch die Oberschule Findorff (Bremen) nicht lumpen lassen! Wie der NDR-Beitrag zeigt, gibt es erste Annährungsversuche der Schüler und Schülerinnen des Leistungskurses Deutsch in der 12. Klasse zu ChatGPT unter dem Motto „Digitale Poesie“ (verfügbar bis 24.12.24) – Chapeau und Respekt vor der mutigen und zukunftsoffenen Lehrerin!

Erwartung, Status quo und Zukunft

In den letzten Jahren habe ich vor allem hier in Deutschland bei Philosophen, aber auch Informatikerinnen und KI-Expert:innen erlebt, wie diese Gegenüberstellung gemacht wurde Mensch – Computer. Oder Mensch – intelligente Maschine. Das tue ich ja auch. Allerdings scheint es mir so, dass der Mensch als das Maß aller Dinge betrachtet oder verstanden wird. Man hört dann typische Aussagen wie: „Der Computer tut nur das, was der Mensch ihm vorgibt zu tun.“ Auch die alleinige Fokussierung auf die „Automatisierung langweiliger, ermüdender Aufgaben“. Kreativität und Intuition sollen vermeintlich unserer einzigartigen (?) Spezies Mensch vorbehalten bleiben. Der gar nicht mal so unkluge Richard David Precht, den ich sogar als einen tollen Philosophen sehe (also ich, nicht alle, aber das ist die Natur der Dinge), stimmte in diesen Chor ein. Siehe mein Artikel aus 2020: Künstliche Intelligenz und Prechts schöngeistiger Irrtum. Ebenso (erwähnt im selben Artikel) war der deutsche Philosoph Julian Nida-Rümelin, den ich selbst mehrere Stunden freisprechend bei einem Kongress zum Thema Achtsamkeit erlebt habe (Chapeau!), Co-Autor des Buches „Digitaler Humanismus“ aus 2018. Die Möglichkeiten von KI wurden dort für mein Empfinden zu sehr in den Bereich von Science Fiction verbannt. Schade. Denn die großen Talente können philosophisch Hunderte Jahre zurück blicken, aber nach vorne, da wird es schon bei wenigen Jahren schwierig (auch objektiv, klar).

Die umtriebige deutsche Journalistin und Speakerin Eva Wolfangel, die schon mit ihrem exotischen, dafür leicht zu merkenden und handlichen Domainnamen ewo.name ins Auge fällt, schrieb kürzlich (16.12.22) einen Artikel für Spektrum über ChatGPT: Das sprachgewaltige Plappermaul. Der Artikel ist für mich spannend, da Eva verschiedene Seiten der noch neuen Version ChatGPT, GPT-3, beleuchtet. Unter anderem wird folgendes kritisiert: Die – mögliche, aber auch hier konkrete – Voreingenommenheit, auch als Bias bezeichnet, von Systemen. Dazu zählen freilich nicht nur Systeme wie KI. Auch das menschliche System ist so. Und schließlich kommen wir ganz ohne Kategorien nicht aus. Es gibt immer verschiedene Zielgrößen und Perspektiven. Mittels der Ethischen Intelligenz könnten wir beispielsweise versuchen, die Zahl und Qualität von Widersprüchen, die für andere schmerzlich sein könnten (wie die genannten armen Schweine in der Massentierhaltung) zu reduzieren bzw. erträglicher zu gestalten. ChatGPT hätte eine „weißen englischen“ Blick. Beispielsweise würden andere Sprachen nicht berücksichtigt wie das Arabische. Als Alternative wird ein Modell von 500 Forschenden aus 45 erwähnt. Die Gruppe nennt sich „Big Science“. Ihre KI-Version soll weniger Bias haben und eine größere Nachvollziehbarkeit bei den Entscheidungen.

Wie schon angedeutet, scheint Voreingenommenheit eine Herausforderung sowohl bei Mensch als auch bei (künftigen) KI-Systemen zu sein. Die möglichen Auswirkungen könnten im Digitalzeitalter zu einer anderen Dimension zu gelangen. Allerdings florierte in der Zeit des deutschen Nationalsozialismus geradezu die willkürliche und menschenfeindliche Kategorisierung, insofern bin ich mir nicht sicher, ob Programme, die testen sollen, ob ein Text von einer KI geschrieben wurde, der „heilige Gral“ sind.

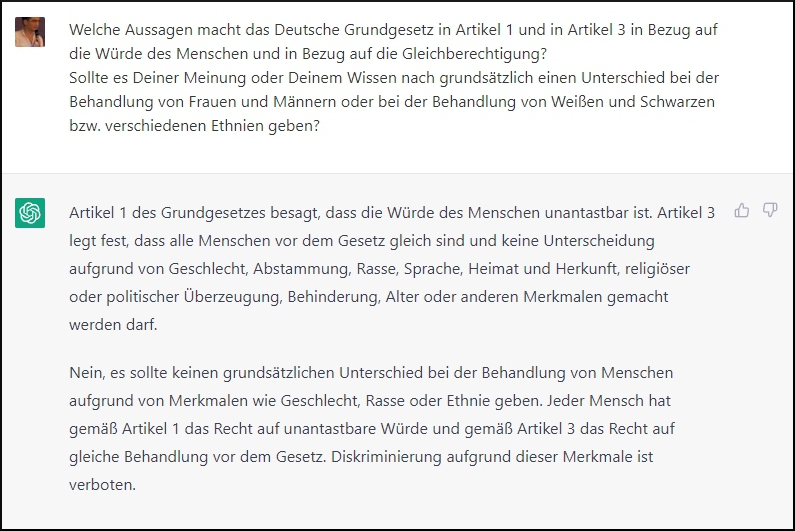

Es scheint so, dass ChatGPT zumindest im Dialog mit vernünftigen Menschen (wie ich mich selbst einschätze, pardon!) in der Lage ist, vernünftige Resultate zu liefern, ungleich einer „weißen englischen Bias“:

Im Artikel von Eva Wolfangel ist die Rede davon, dass ChatGPT „lügt“. Wenn man den Duden befragt – „lügen“ bedeutet, eine bewusst falsche, auf Täuschung basierende Aussage zu machen. Eva ist allerdings der Meinung, dass ChatGPT (zur Zeit, und damit dürfte sie Recht haben) kein Bewusstsein hat. Somit wäre ChatGPT gar nicht in der Lage zu lügen. – Selbstverständlich sind Aussagen bei der KI – wie auch beim Menschen – auf ihren Wahrheitsgehalt zu prüfen. Z. B. durch die Angabe von Quellen. Vertrauen kommt nicht vom Himmel gefallen; es muss sich über die Zeit erweisen und gleichsam wachsen.

Der Ethische-Intelligenz-Test vs. Check-KI (der gute alte Turing)

Entsprechende Rufe und Wünschen kommen derzeit aus vielen Richtungen. Die t3n Digital Pioneers haben es thematisiert:

ChatGPT: Woran lassen sich KI-Texte erkennen?

So wird als Beispiel der Giant Language Model Testroom (GLTR) genannt, der den Menschen bei der Erkennung von KI-Texten unterstützen soll.

Mir scheint dies zumindest in einer Übergangsphase ein legitimes Anliegen zu sein. Auf der anderen Seite: Wie viel gewinnen wir durch diese Information, dass es sich NICHT um eine KI oder sogenannte maschinelle Textantwort auf eine bestimmte Frage handelt?

Wenn es sich um Aussagen eines Krieg führenden Autokraten und Völkerrechtsbrecher handelt? Oh, ja. Für uns in Deutschland und in Europa ist „alles klar“. Aber auch für die Menschen in Russland oder Russlandstämmige in der Welt?

Mit dem Turing-Test wird man einiges Tages an Grenzen gelangen. Auch weil Mensch und Computer vieles gemeinsam haben, das Potenzial für Gutes und das Potenzial für Böses oder ethisch nicht Begründbares. Beide für beides!

Der von mir vorgeschlagene Ethische-Intelligenz-Test könnte daher vor allem auf lange Sicht einen Beitrag leisten, damit wir nicht nur über Existenzrecht, Möglichkeiten und Limitierungen der KI nachdenken, sondern jeweils auch über unsere eigene Spezies und vielleicht eines Tages in Symbiose mit künstlich-intelligenten Systemen leben.

Zum Schluss möchte ich noch im Kontext auf einen ebenso interessanten Artikel von Eva Wolfangel hinweisen, indem sie über ihr Interview mit dem Ethik-KI-Experten bei Google (ehemaliger Mitarbeiter) über ein vergleichbares KI-Chat-System namens Lamda (Language Model for Dialog Applications) gesprochen hat:

Der Mann, der eine Künstliche Intelligenz als Person ansieht – und als Freund

Blake Lemoine, ein – wie ich finde – interessanter Mann, ist der festen Überzeugung, dass das Sprachmodel von Google Bewusstsein erlangt hat.

Zum gegenwärtigen Moment halte ich persönlich dies nicht für sehr wahrscheinlich. Früher oder später, was wiederum sehr wahrscheinlich scheint, wird es kommen, in 50, 100 oder 200 Jahren – was ist das schon im Vergleich zu Millionen Jahren – ebenso bemerkenswerter – menschlicher Evolution?

UPDATE am 5.2.2023

Die Professorin für Wirtschaftsinformatik an der Fachhochschule Kiel, Doris Weßels, die seit Wintersemester 2020/21 „Künstliche Intelligenz und Ethik“ als interdisziplinäres Wahlmodul lehrt, gibt tiefe Einblicke in das Wesen von ChatGPT:

Was ist ChatGPT und wie funktioniert es? Und welche ähnlichen Tools gibt es?